Checkpoint

Disable and re-enable the Dataflow API

/ 20

Create a BigQuery Dataset (name: taxirides)

/ 20

Create a table in BigQuery Dataset

/ 20

Create a Cloud Storage bucket

/ 20

Run the Pipeline

/ 20

Dataflow: Qwik Start - Template

GSP192

Ringkasan

Di lab ini, Anda akan belajar cara membuat pipeline streaming menggunakan salah satu template Cloud Dataflow Google. Lebih tepatnya, Anda akan menggunakan template Cloud Pub/Sub to BigQuery, yang membaca pesan yang ditulis dalam JSON dari topik Pub/Sub dan mengirimnya ke tabel BigQuery. Anda dapat menemukan dokumentasi untuk template ini di bagian Panduan penggunaan template yang disediakan Google.

Anda akan diberi opsi untuk menggunakan command line Cloud Shell atau Konsol Cloud untuk membuat set data dan tabel BigQuery. Pilih satu metode yang akan digunakan, lalu lanjutkan dengan metode tersebut hingga akhir lab. Jika Anda ingin merasakan pengalaman menggunakan kedua metode tersebut, jalankan melalui lab ini untuk kedua kalinya.

Penyiapan

Sebelum mengklik tombol Mulai Lab

Baca petunjuk ini. Lab memiliki timer dan Anda tidak dapat menjedanya. Timer, yang dimulai saat Anda mengklik Start Lab, akan menampilkan durasi ketersediaan resource Google Cloud untuk Anda.

Lab praktik ini dapat Anda gunakan untuk melakukan sendiri aktivitas lab di lingkungan cloud sungguhan, bukan di lingkungan demo atau simulasi. Untuk mengakses lab ini, Anda akan diberi kredensial baru yang bersifat sementara dan dapat digunakan untuk login serta mengakses Google Cloud selama durasi lab.

Untuk menyelesaikan lab ini, Anda memerlukan:

- Akses ke browser internet standar (disarankan browser Chrome).

- Waktu untuk menyelesaikan lab. Ingat, setelah dimulai, lab tidak dapat dijeda.

Cara memulai lab dan login ke Google Cloud Console

-

Klik tombol Start Lab. Jika Anda perlu membayar lab, jendela pop-up akan terbuka untuk memilih metode pembayaran. Di sebelah kiri adalah panel Lab Details dengan berikut ini:

- Tombol Open Google Console

- Waktu tersisa

- Kredensial sementara yang harus Anda gunakan untuk lab ini

- Informasi lain, jika diperlukan, untuk menyelesaikan lab ini

-

Klik Open Google Console. Lab akan menjalankan resource, lalu membuka tab lain yang menampilkan halaman Login.

Tips: Atur tab di jendela terpisah secara berdampingan.

Catatan: Jika Anda melihat dialog Choose an account, klik Use Another Account. -

Jika perlu, salin Username dari panel Lab Details dan tempel ke dialog Sign in. Klik Next.

-

Salin Password dari panel Lab Details dan tempel ke dialog Welcome. Klik Next.

Penting: Anda harus menggunakan kredensial dari panel sebelah kiri. Jangan menggunakan kredensial Google Cloud Skills Boost. Catatan: Menggunakan akun Google Cloud sendiri untuk lab ini dapat dikenai biaya tambahan. -

Klik halaman berikutnya:

- Setujui persyaratan dan ketentuan.

- Jangan tambahkan opsi pemulihan atau autentikasi 2 langkah (karena ini akun sementara).

- Jangan daftar uji coba gratis.

Setelah beberapa saat, Cloud Console akan terbuka di tab ini.

Mengaktifkan Cloud Shell

Cloud Shell adalah mesin virtual yang dilengkapi dengan berbagai alat pengembangan. Mesin virtual ini menawarkan direktori beranda persisten berkapasitas 5 GB dan berjalan di Google Cloud. Cloud Shell menyediakan akses command-line untuk resource Google Cloud Anda.

- Klik Activate Cloud Shell

di bagian atas konsol Google Cloud.

Setelah terhubung, Anda sudah diautentikasi, dan project ditetapkan ke PROJECT_ID Anda. Output berisi baris yang mendeklarasikan PROJECT_ID untuk sesi ini:

gcloud adalah alat command line untuk Google Cloud. Alat ini sudah terinstal di Cloud Shell dan mendukung pelengkapan command line.

- (Opsional) Anda dapat menampilkan daftar nama akun yang aktif dengan perintah ini:

-

Klik Authorize.

-

Output Anda sekarang akan terlihat seperti ini:

Output:

- (Opsional) Anda dapat menampilkan daftar project ID dengan perintah ini:

Output:

Contoh output:

gcloud yang lengkap di Google Cloud, baca panduan ringkasan gcloud CLI.

Memastikan Dataflow API berhasil diaktifkan kembali

Untuk memastikan akses ke API yang diperlukan, mulai ulang koneksi ke Dataflow API.

-

Di Konsol Cloud, masukkan "Dataflow API" di kotak penelusuran teratas. Klik hasil untuk Dataflow API.

-

Klik Manage.

-

Klik Disable API.

JIka diminta untuk mengonfirmasi, klik Disable.

- Klik Enable.

Jika API sudah diaktifkan kembali, halaman akan menampilkan opsi untuk menonaktifkannya.

Menguji tugas yang sudah selesai

Klik Check my progress untuk memverifikasi tugas yang telah diselesaikan.

Tugas 1. Membuat set data dan tabel Cloud BigQuery menggunakan Cloud Shell

Pertama-tama, mari kita buat set data dan tabel BigQuery.

bq. Lompat ke bagian berikutnya jika Anda ingin menjalankan lab ini menggunakan konsol.

- Jalankan perintah berikut untuk membuat set data yang disebut

taxirides:

Output Anda akan terlihat seperti ini:

Menguji tugas yang sudah selesai

Klik Check my progress untuk memverifikasi tugas yang telah diselesaikan. Jika berhasil membuat set data BigQuery, Anda akan melihat skor penilaian.

Sekarang setelah set data dibuat, Anda akan menggunakannya pada langkah berikut untuk membuat instance tabel BigQuery.

- Jalankan perintah berikut untuk melakukannya:

Output Anda akan terlihat seperti ini:

Menguji tugas yang sudah selesai

Klik Check my progress untuk memverifikasi tugas yang telah diselesaikan. Jika berhasil membuat tabel dalam set data BigQuery, Anda akan melihat skor penilaian.

Sepintas lalu, perintah bq mk terlihat agak kompleks. Namun, dengan bantuan dari dokumentasi command line BigQuery, kita dapat menguraikan prosesnya. Sebagai contoh, dokumentasi memberi informasi lebih lanjut tentang skema:

- Baik berupa jalur ke file skema JSON lokal maupun daftar yang dipisahkan koma dari definisi kolom dalam format

[FIELD]:[DATA_TYPE],[FIELD]:[DATA_TYPE].

Dalam hal ini, kita menggunakan format yang kedua, yaitu daftar yang dipisahkan koma.

Membuat bucket Cloud Storage

Setelah membuat instance tabel, mari kita membuat bucket.

Gunakan Project ID sebagai nama bucket untuk memastikan nama unik secara global:

- Jalankan perintah berikut untuk melakukannya:

Menguji tugas yang sudah selesai

Klik Check my progress untuk memverifikasi tugas yang telah diselesaikan. Jika berhasil membuat bucket Cloud Storage, Anda akan melihat skor penilaian.

Setelah membuat bucket, scroll ke bawah ke bagian Run the Pipeline.

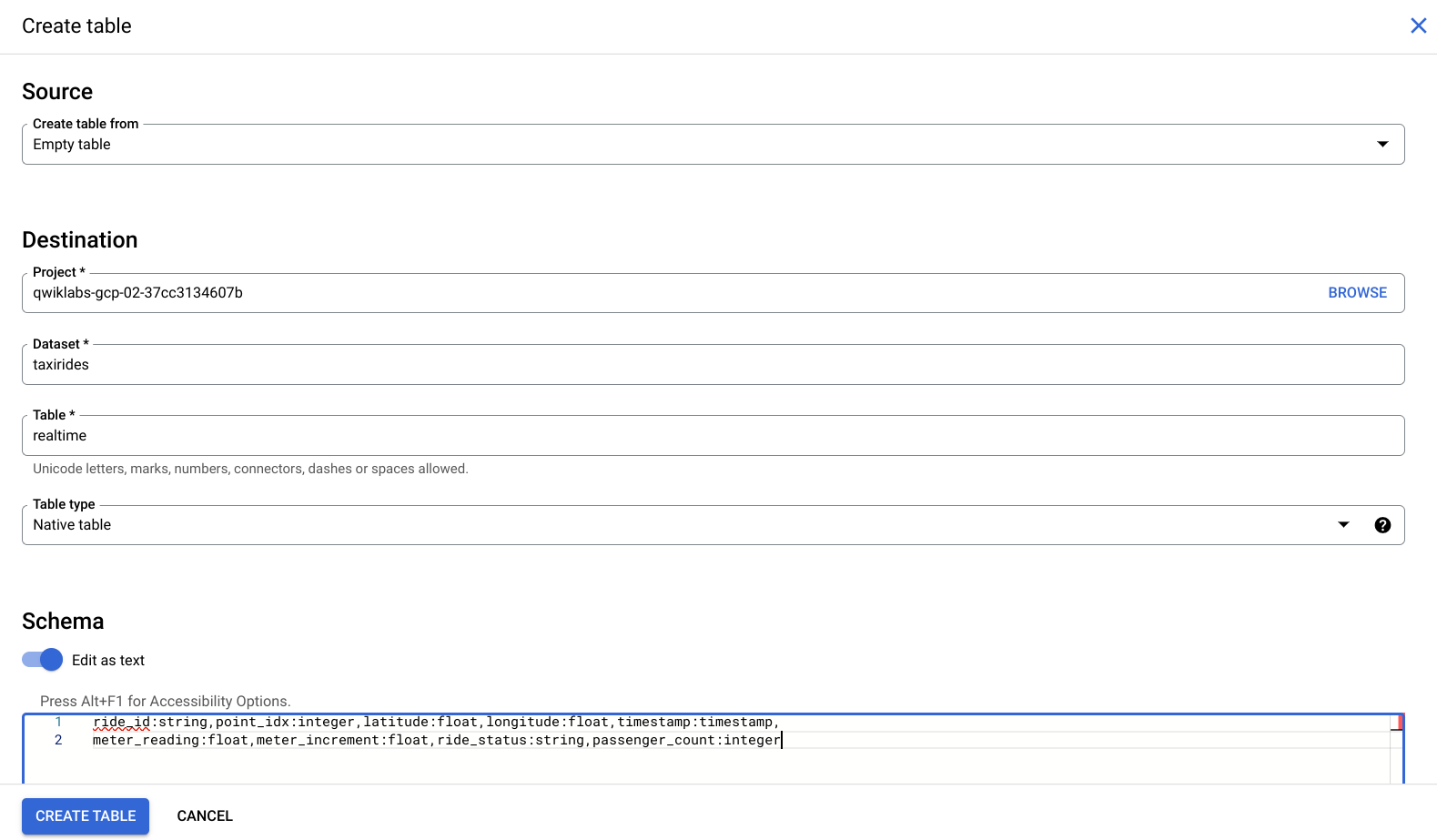

Tugas 2. Membuat set data dan tabel Cloud BigQuery menggunakan Konsol Cloud

-

Dari menu di sebelah kiri, di bagian Big Data, klik BigQuery.

-

Kemudian, klik Done.

-

Klik tiga titik di samping nama project Anda di bagian Explorer, lalu klik Create dataset.

-

Masukkan

taxiridessebagai ID set data Anda: -

Pilih us (multiple regions in United States) di lokasi Data.

-

Tetap gunakan setelan default untuk semua setelan lainnya, lalu klik CREATE DATASET.

Menguji tugas yang sudah selesai

Klik Check my progress untuk memverifikasi tugas yang telah diselesaikan. Jika berhasil membuat set data BigQuery, Anda akan melihat skor penilaian.

-

Saat ini Anda seharusnya dapat melihat set data

taxiridesdi bawah project ID, di konsol sebelah kiri. -

Klik tiga titik di samping set data

taxiridesdan pilih Open. -

Lalu pilih CREATE TABLE di sisi kanan konsol.

-

Pada input Destination > Table Name, masukkan

realtime. -

Di bagian Schema, aktifkan tombol pengalih Edit as text, lalu masukkan perintah berikut:

Konsol Anda akan tampak seperti berikut:

- Sekarang, klik Create table.

Menguji tugas yang sudah selesai

Klik Check my progress untuk memverifikasi tugas yang telah diselesaikan. Jika berhasil membuat tabel dalam set data BigQuery, Anda akan melihat skor penilaian.

Membuat bucket Cloud Storage

-

Kembali ke Konsol Cloud dan buka Cloud Storage > Buckets > Create bucket.

-

Gunakan Project ID sebagai nama bucket untuk memastikan nama unik secara global:

-

Tetap gunakan setelan default untuk semua setelan lainnya, lalu klik Create.

Menguji tugas yang sudah selesai

Klik Check my progress untuk memverifikasi tugas yang telah diselesaikan. Jika berhasil membuat bucket Cloud Storage, Anda akan melihat skor penilaian.

Tugas 3. Menjalankan pipeline

Deploy Template Dataflow berikut:

Pada Konsol Google Cloud, di Navigation menu, klik Dataflow > Jobs, dan Anda akan melihat tugas dataflow Anda.

Baca dokumen ini untuk mengetahui informasi lebih lanjut.

Menguji tugas yang sudah selesai

Klik Check my progress untuk memverifikasi tugas yang telah diselesaikan. Jika telah berhasil menjalankan pipeline Dataflow, Anda akan melihat skor penilaian.

Anda akan menyaksikan resource Anda dibuat dan siap digunakan.

Sekarang, mari kita lihat data yang ditulis ke BigQuery dengan mengklik BigQuery yang ada di Navigation menu.

- Ketika UI BigQuery terbuka, Anda akan melihat set data taxirides ditambahkan di bagian nama project Anda dan tabel realtime di bawahnya.

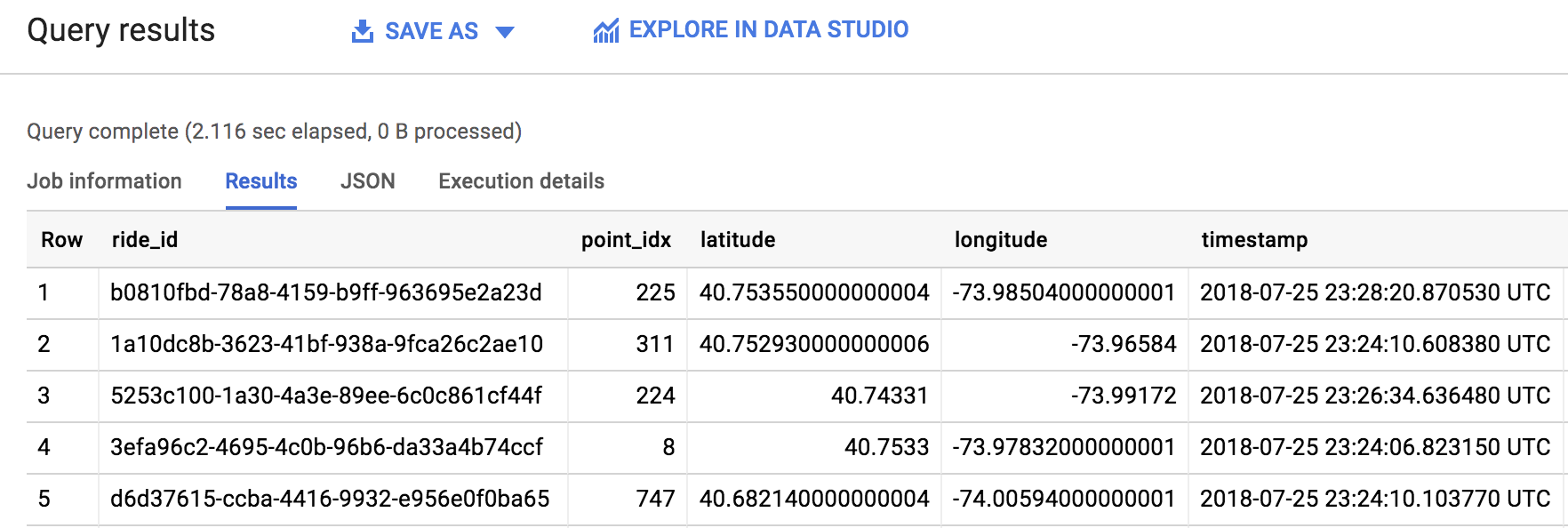

Tugas 4. Mengirim kueri

Anda dapat mengirimkan kueri menggunakan SQL standar.

- Di Editor BigQuery, tambahkan perintah berikut untuk membuat kueri data di project Anda:

- Sekarang, klik RUN:

Jika Anda mengalami masalah atau error, jalankan kueri lagi (pipeline membutuhkan waktu satu menit untuk memulai.)

- Ketika kueri berhasil berjalan, Anda akan melihat output di panel Query Results seperti yang ditunjukkan di bawah ini:

Kerja bagus! Anda baru saja menarik 1000 perjalanan dengan taksi dari topik Pub/Sub dan memasukkannya ke tabel BigQuery. Seperti yang Anda lihat sendiri, template adalah cara yang praktis dan mudah digunakan untuk menjalankan tugas Dataflow. Pastikan untuk mempelajari beberapa Template Google lainnya di bagian Panduan penggunaan template yang disediakan Google di Dokumentasi Dataflow.

Tugas 5. Menguji pemahaman Anda

Di bawah ini terdapat pertanyaan pilihan ganda untuk memperkuat pemahaman Anda tentang konsep lab ini. Jawab pertanyaan tersebut sebaik mungkin.

Selamat!

Menyelesaikan Quest Anda

Lab mandiri ini adalah bagian dari Quest Baseline: Data, ML, AI. Quest adalah serangkaian lab terkait yang membentuk jalur pembelajaran. Dengan menyelesaikan quest ini, Anda mendapatkan badge sebagai pengakuan atas pencapaian Anda. Anda dapat menunjukkan satu atau beberapa badge kepada orang lain secara publik dan menautkannya di resume online atau akun media sosial Anda. Daftar ke Quest ini atau Quest apa pun yang berisi lab ini dan segera dapatkan kredit penyelesaian. Lihat Katalog Google Cloud Skills Boost untuk melihat semua Quest yang tersedia.

Langkah berikutnya/Pelajari lebih lanjut

Lab ini merupakan bagian dari rangkaian lab yang disebut Qwik Start. Lab ini dirancang agar Anda dapat mencoba berbagai fitur yang tersedia dengan Google Cloud. Telusuri "Qwik Starts" di katalog Google Cloud Skills Boost untuk menemukan lab berikutnya yang ingin Anda ikuti.

Sertifikasi dan pelatihan Google Cloud

...membantu Anda mengoptimalkan teknologi Google Cloud. Kelas kami mencakup keterampilan teknis dan praktik terbaik untuk membantu Anda memahami dengan cepat dan melanjutkan proses pembelajaran. Kami menawarkan pelatihan tingkat dasar hingga lanjutan dengan opsi on demand, live, dan virtual untuk menyesuaikan dengan jadwal Anda yang sibuk. Sertifikasi membantu Anda memvalidasi dan membuktikan keterampilan serta keahlian Anda dalam teknologi Google Cloud.

Manual Terakhir Diperbarui pada 10 November 2023

Lab Terakhir Diuji pada 10 November 2023

Hak cipta 2024 Google LLC Semua hak dilindungi undang-undang. Google dan logo Google adalah merek dagang dari Google LLC. Semua nama perusahaan dan produk lain mungkin adalah merek dagang masing-masing perusahaan yang bersangkutan.