Points de contrôle

Configure a Service Account & IAM permissions

/ 20

Configure credential file for a Service Account

/ 20

Modify the application to save text from images to Cloud Storage

/ 20

Modify the appliction to translate text using the Language API

/ 20

Query the BigQuery table

/ 20

Intégration avec les API Machine Learning : atelier challenge

- GSP329

- Présentation

- Scénario du challenge

- Tâche 1 : Configurer un compte de service pour accéder aux API de machine learning, à BigQuery et à Cloud Storage

- Tâche 2 : Créer et télécharger le fichier d'identifiants de votre compte de service

- Tâche 3 : Modifier le script Python pour extraire le texte des fichiers image

- Tâche 4 : Modifier le script Python pour traduire le texte à l'aide de l'API Translation

- Tâche 5 : Identifier la langue la plus fréquemment utilisée sur les panneaux dans l'ensemble de données

- Conseils et astuces

- Félicitations !

GSP329

Présentation

Dans un atelier challenge, vous devez suivre un scénario et effectuer une série de tâches. Aucune instruction détaillée n'est fournie : vous devez utiliser les compétences acquises au cours des ateliers de la quête correspondante pour déterminer comment procéder par vous-même. Vous saurez si vous avez exécuté correctement les différentes tâches grâce au score calculé automatiquement (affiché sur cette page).

Lorsque vous participez à un atelier challenge, vous n'étudiez pas de nouveaux concepts Google Cloud. Vous allez approfondir les compétences précédemment acquises. Par exemple, vous devrez modifier les valeurs par défaut ou encore examiner des messages d'erreur pour corriger vous-même les problèmes.

Pour atteindre le score de 100 %, vous devez mener à bien l'ensemble des tâches dans le délai imparti.

Cet atelier est recommandé aux participants inscrits à la quête Integrate with Machine Learning APIs. Êtes-vous prêt pour le challenge ?

Compétences évaluées

- Accorder au compte de service les droits BigQuery et Cloud Storage appropriés

- Créer et télécharger le fichier d'identifiants d'un compte de service pour fournir des identifiants Google Cloud à une application Python

- Modifier un script Python pour extraire du texte à partir de fichiers image avec l'API Google Cloud Vision

- Modifier un script Python pour traduire du texte à l'aide de l'API Google Translate

- Identifier les langues présentes dans les données extraites en exécutant une requête SQL BigQuery

Préparation

Avant de cliquer sur le bouton "Démarrer l'atelier"

Lisez ces instructions. Les ateliers sont minutés, et vous ne pouvez pas les mettre en pause. Le minuteur, qui démarre lorsque vous cliquez sur Démarrer l'atelier, indique combien de temps les ressources Google Cloud resteront accessibles.

Cet atelier pratique vous permet de suivre vous-même les activités dans un véritable environnement cloud, et non dans un environnement de simulation ou de démonstration. Nous vous fournissons des identifiants temporaires pour vous connecter à Google Cloud le temps de l'atelier.

Pour réaliser cet atelier :

- vous devez avoir accès à un navigateur Internet standard (nous vous recommandons d'utiliser Chrome) ;

- vous disposez d'un temps limité ; une fois l'atelier commencé, vous ne pouvez pas le mettre en pause.

Démarrer l'atelier et se connecter à la console Google Cloud

-

Cliquez sur le bouton Démarrer l'atelier. Si l'atelier est payant, un pop-up s'affiche pour vous permettre de sélectionner un mode de paiement. Sur la gauche, vous trouverez le panneau Détails concernant l'atelier, qui contient les éléments suivants :

- Le bouton Ouvrir la console Google

- Le temps restant

- Les identifiants temporaires que vous devez utiliser pour cet atelier

- Des informations complémentaires vous permettant d'effectuer l'atelier

-

Cliquez sur Ouvrir la console Google. L'atelier lance les ressources, puis ouvre la page Se connecter dans un nouvel onglet.

Conseil : Réorganisez les onglets dans des fenêtres distinctes, placées côte à côte.

Remarque : Si la boîte de dialogue Sélectionner un compte s'affiche, cliquez sur Utiliser un autre compte. -

Si nécessaire, copiez le nom d'utilisateur inclus dans le panneau Détails concernant l'atelier et collez-le dans la boîte de dialogue Se connecter. Cliquez sur Suivant.

-

Copiez le mot de passe inclus dans le panneau Détails concernant l'atelier et collez-le dans la boîte de dialogue de bienvenue. Cliquez sur Suivant.

Important : Vous devez utiliser les identifiants fournis dans le panneau de gauche. Ne saisissez pas vos identifiants Google Cloud Skills Boost. Remarque : Si vous utilisez votre propre compte Google Cloud pour cet atelier, des frais supplémentaires peuvent vous être facturés. -

Accédez aux pages suivantes :

- Acceptez les conditions d'utilisation.

- N'ajoutez pas d'options de récupération ni d'authentification à deux facteurs (ce compte est temporaire).

- Ne vous inscrivez pas aux essais offerts.

Après quelques instants, la console Cloud s'ouvre dans cet onglet.

Scénario du challenge

Vous venez de décrocher un poste dans l'équipe d'analyse de Jooli Inc. Vous devez contribuer au développement et à l'évaluation d'ensembles de données pour les projets de machine learning de votre entreprise. Les tâches courantes incluent la préparation, le nettoyage et l'analyse de divers ensembles de données.

Vous êtes censé disposer des compétences et connaissances requises pour ces tâches. Ne vous attendez donc pas à recevoir des instructions détaillées.

Votre challenge

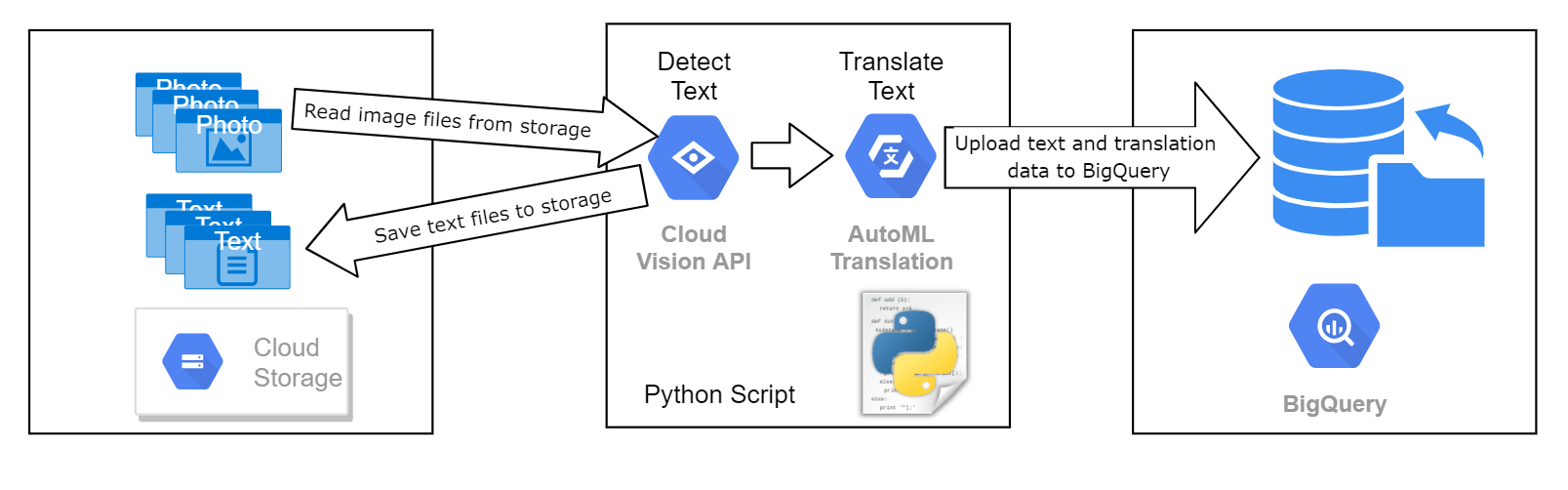

Vous devez développer un processus d'analyse d'images de panneaux afin d'extraire et de traduire le texte qu'elles contiennent. Les informations extraites serviront à classer les images dans le cadre d'un projet de machine learning. Cet ensemble permettra alors d'entraîner et d'évaluer le modèle. Les images contiennent toutes du texte, mais en différentes langues. Elles sont stockées dans un bucket Cloud Storage que nous vous avons fourni.

Vous devez traiter chacun des fichiers image à l'aide d'un script Python qui les envoie vers l'API Google Vision afin d'identifier le texte qui s'y trouve. Le texte de chaque image et l'image elle-même doivent ensuite être enregistrés séparément dans Cloud Storage. Si le texte d'origine n'est pas en

Ce diagramme décrit le processus.

Les données textuelles traitées doivent ensuite être enregistrées dans une table BigQuery existante appelée image_text_detail, dans un ensemble de données de votre projet intitulé image_classification_dataset.

Un membre de votre équipe a commencé à travailler sur le code de traitement des images. Il s'est appuyé sur un script Python employé précédemment pour traiter un ensemble de fichiers texte avec l'API Natural Language. Il a été affecté à un autre projet et vous devez terminer son travail.

Le script est presque terminé, et la version que vous récupérez accède au bucket de stockage et effectue une itération sur chaque fichier image trouvé. Toutefois, les appels d'API spécifiques permettant d'identifier le texte dans chaque image et de l'envoyer vers l'API Translation n'ont pas encore été intégrés.

Vous disposez d'une copie de ce script Python et d'un ensemble d'images d'exemple dans un bucket Cloud Storage portant le même nom que l'ID du projet de l'atelier.

Votre collègue a identifié les parties inachevées du script et commenté les appels d'API sur lesquels vous devez travailler. Le script comporte trois parties inachevées que vous devez terminer pour créer les appels d'API Machine Learning appropriés. Ces parties sont précédées d'un commentaire portant le libellé # TBD:.

La dernière ligne du code importe les données de résultat dans BigQuery. Dans le script, cette ligne est désactivée par un caractère de commentaire. Une fois que vous êtes satisfait du fonctionnement du reste du script, supprimez le caractère de commentaire pour activer la dernière ligne.

Avant de travailler sur le script, vous devez préparer votre environnement en créant un compte de service avec les autorisations appropriées et télécharger le fichier d'identifiants de ce compte. Une fois en possession des identifiants du compte de service, vous pouvez modifier le script Python et l'exécuter pour traiter les fichiers image.

Pour terminer le challenge, vous devez importer le texte d'origine extrait, la langue et le texte traduit de toutes les images dans la table BigQuery appelée image_text_detail. Le code pour effectuer cette tâche se trouve dans le script, mais vous devez supprimer les caractères de commentaire de la dernière ligne pour l'activer.

Après avoir traité les fichiers image à l'aide du script Python modifié et avoir importé les données dans BigQuery, vous devez vérifier que les données des images ont bien été traitées en exécutant la requête suivante dans BigQuery :

Cette requête indique le nombre de panneaux pour chaque langue présents dans l'ensemble des images d'exemple.

Tâche 1 : Configurer un compte de service pour accéder aux API de machine learning, à BigQuery et à Cloud Storage

- Créez un compte de service pour fournir les identifiants au script.

- Une fois le compte créé, liez les rôles

et au compte de service afin d'attribuer les autorisations IAM requises pour traiter les fichiers à partir de Cloud Storage. Intégrez ensuite les données de résultat dans une table BigQuery. Vérifier que le compte de service existe bien avec les autorisations d'accès administrateur à BigQuery et Cloud Storage

Tâche 2 : Créer et télécharger le fichier d'identifiants de votre compte de service

- Après avoir configuré les autorisations du compte de service, téléchargez le fichier d'identifiants IAM du compte de service au format JSON.

- N'oubliez pas de configurer la variable d'environnement qui fournit le nom du fichier d'identifiants au script Python.

Vérifier que le fichier d'identifiants IAM du compte de service a bien été créé

Tâche 3 : Modifier le script Python pour extraire le texte des fichiers image

-

Copiez le fichier

analyze-images-v2.pyà partir du bucket Cloud Storage créé pour vous dans Cloud Shell. -

Vous devez modifier ce script Python pour extraire le texte des fichiers image stockés dans le bucket du projet, puis enregistrer les données textuelles de chaque fichier dans un fichier texte qui sera réécrit dans le même bucket. N'oubliez pas que les parties du script où vous devez ajouter le code pour accéder aux API sont signalées par le commentaire

# TBD. -

Après avoir modifié la première partie du script pour extraire les données textuelles des fichiers image à l'aide de l'API Cloud Vision, vous devez exécuter le script partiellement terminé afin de vérifier votre progression et de vous assurer que vous êtes sur la bonne voie.

Tâche 4 : Modifier le script Python pour traduire le texte à l'aide de l'API Translation

-

À présent, modifiez la deuxième partie du script Python pour identifier dans les données textuelles extraites par l'API Vision celles qui sont en

, puis les traduire en avec l'API Translation. Vérifier que l'application parvient à traduire le texte et à stocker le résultat dans BigQuery

Tâche 5 : Identifier la langue la plus fréquemment utilisée sur les panneaux dans l'ensemble de données

- Après avoir modifié le script pour rechercher et traduire le texte dans les images, supprimez le caractère de commentaire à la fin du script pour activer la ligne de code qui importe les données dans BigQuery.

- Une fois les données importées dans BigQuery, vérifiez que toutes les données nécessaires ont été importées dans BigQuery en exécutant une requête qui calcule le nombre de fois qu'un texte dans une autre langue est trouvé.

Exécuter une requête BigQuery pour trouver le nombre d'occurrences de chaque langue dans les images

Conseils et astuces

-

Conseil 1 : Vous devez définir une variable d'environnement pour fournir les détails du fichier d'identifiants qui permet au script Python d'accéder aux API Google Cloud.

-

Conseil 2 : Pour plus d'informations sur l'appel d'API document_text_detection du client API Vision, consultez la documentation de référence des API Python sur le client API Vision. Pour des informations sur l'objet du résultat de l'annotation de l'API Vision, consultez la documentation de référence des API Python sur les objets API Vision.

-

Conseil 3 : Pour plus d'informations sur l'appel d'API translate du client API Translation, consultez la documentation des API Python sur le client API Translation V2.

Félicitations !

Vous avez développé un processus pour analyser des images de panneaux afin d'extraire et de traduire le texte qu'elles contiennent.

Terminer votre quête

Cet atelier d'auto-formation fait partie de la quête Integrate with Machine Learning APIs. Une quête est une série d'ateliers associés qui constituent un parcours de formation. Si vous terminez cette quête, vous obtenez un badge attestant de votre réussite. Vous pouvez rendre publics les badges que vous recevez et ajouter leur lien dans votre CV en ligne ou sur vos comptes de réseaux sociaux. Inscrivez-vous à cette quête pour obtenir immédiatement les crédits associés. Découvrez toutes les quêtes disponibles dans le catalogue Google Cloud Skills Boost.

Formations et certifications Google Cloud

Les formations et certifications Google Cloud vous aident à tirer pleinement parti des technologies Google Cloud. Nos cours portent sur les compétences techniques et les bonnes pratiques à suivre pour être rapidement opérationnel et poursuivre votre apprentissage. Nous proposons des formations pour tous les niveaux, à la demande, en salle et à distance, pour nous adapter aux emplois du temps de chacun. Les certifications vous permettent de valider et de démontrer vos compétences et votre expérience en matière de technologies Google Cloud.

Dernière mise à jour du manuel : 5 décembre 2023

Dernier test de l'atelier : 5 décembre 2023

Copyright 2024 Google LLC Tous droits réservés. Google et le logo Google sont des marques de Google LLC. Tous les autres noms d'entreprises et de produits peuvent être des marques des entreprises auxquelles ils sont associés.