チェックポイント

Create Compute Engine instance with the necessary API access

/ 20

Install software

/ 20

Ingest USGS data

/ 20

Transform the data

/ 20

Create bucket and Store data

/ 20

レンタル VM での地震データの処理

GSP008

概要

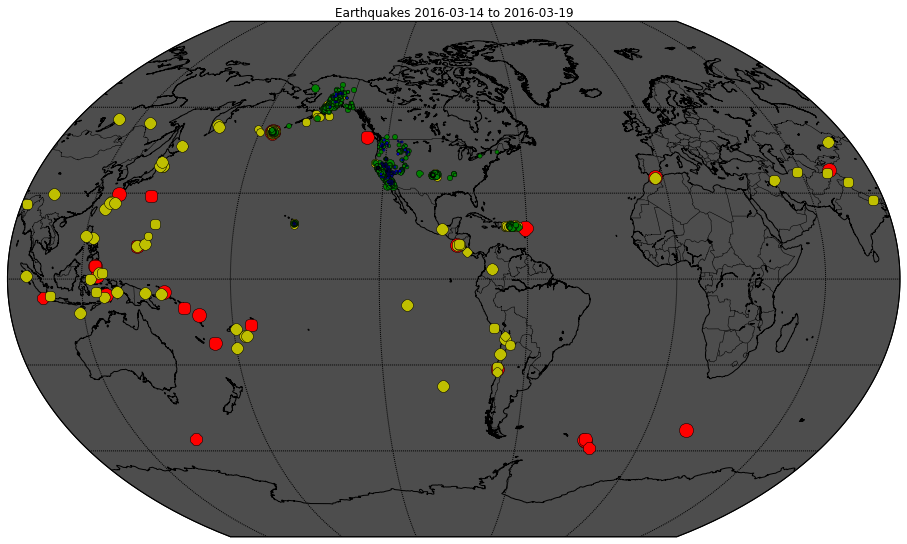

Google Cloud を使用して地震データ処理用に仮想マシンを設定すると、細かな IT 業務から解放されて科学的な研究目標に集中できるようになります。データを取り込んで処理し、さまざまな形式で結果を表示することができます。このラボでは、アメリカ地質調査所(USGS)が公開しているリアルタイムの地震データを取り込んで、次のような地図を作成します。

このラボではまず、仮想マシンをスピンアップしてリモートからアクセスします。次に、データを取得、処理、公開するためのパイプラインを手動で作成します。

ラボの内容

このラボでは、次の方法について学びます。

- 特定のセキュリティ権限を持つ Compute Engine インスタンスを作成する。

- インスタンスに SSH 接続する。

- ソフトウェア パッケージ Git(ソースコードのバージョン管理用)をインストールする。

- Compute Engine インスタンスにデータを取り込む。

- Compute Engine インスタンスでデータを変換する。

- 変換したデータを Cloud Storage に保存する。

- Cloud Storage のデータをウェブに公開する。

設定

[ラボを開始] ボタンをクリックする前に

こちらの手順をお読みください。ラボの時間は記録されており、一時停止することはできません。[ラボを開始] をクリックするとスタートするタイマーは、Google Cloud のリソースを利用できる時間を示しています。

このハンズオンラボでは、シミュレーションやデモ環境ではなく、実際のクラウド環境を使ってご自身でラボのアクティビティを行うことができます。そのため、ラボの受講中に Google Cloud にログインおよびアクセスするための、新しい一時的な認証情報が提供されます。

このラボを完了するためには、下記が必要です。

- 標準的なインターネット ブラウザ(Chrome を推奨)

- ラボを完了するために十分な時間を確保してください。ラボをいったん開始すると一時停止することはできません。

ラボを開始して Google Cloud コンソールにログインする方法

-

[ラボを開始] ボタンをクリックします。ラボの料金をお支払いいただく必要がある場合は、表示されるポップアップでお支払い方法を選択してください。 左側の [ラボの詳細] パネルには、以下が表示されます。

- [Google コンソールを開く] ボタン

- 残り時間

- このラボで使用する必要がある一時的な認証情報

- このラボを行うために必要なその他の情報(ある場合)

-

[Google コンソールを開く] をクリックします。 ラボでリソースが起動し、別のタブで [ログイン] ページが表示されます。

ヒント: タブをそれぞれ別のウィンドウで開き、並べて表示しておきましょう。

注: [アカウントの選択] ダイアログが表示されたら、[別のアカウントを使用] をクリックします。 -

必要に応じて、[ラボの詳細] パネルから [ユーザー名] をコピーして [ログイン] ダイアログに貼り付けます。[次へ] をクリックします。

-

[ラボの詳細] パネルから [パスワード] をコピーして [ようこそ] ダイアログに貼り付けます。[次へ] をクリックします。

重要: 認証情報は左側のパネルに表示されたものを使用してください。Google Cloud Skills Boost の認証情報は使用しないでください。 注: このラボでご自身の Google Cloud アカウントを使用すると、追加料金が発生する場合があります。 -

その後次のように進みます。

- 利用規約に同意してください。

- 一時的なアカウントなので、復元オプションや 2 要素認証プロセスは設定しないでください。

- 無料トライアルには登録しないでください。

その後このタブで Cloud Console が開きます。

タスク 1. 必要な API にアクセスできる Compute Engine インスタンスを作成する

-

Compute Engine インスタンスを作成するには、ナビゲーション メニューで [Compute Engine] > [VM インスタンス] をクリックします。

-

[作成] をクリックし、「インスタンスの作成」フォームが読み込まれるまで待ちます。

-

デフォルトのリージョンとゾーンを使用してインスタンスを作成します。

-

[ブートディスク] セクションで、[変更] をクリックします。

-

[バージョン] を [Debian GNU/Linux 10 (buster)] に変更します。

-

その他の設定はそのままにして、[選択] をクリックします。

-

Compute Engine デフォルト サービス アカウントの [ID と API アクセス] を [すべての Cloud API に完全アクセス権を許可] に変更してから、[作成] をクリックします。

インスタンスが作成されると緑色のチェックマークが表示されます。

下の [進行状況を確認] をクリックして、このラボの進捗状況を確認します。

タスク 2. インスタンスに SSH 接続する

リモートで Secure Shell(SSH)を使用して Compute Engine インスタンスにアクセスすることができます。

- 新たに作成した VM の横にある [SSH] ボタンをクリックします。

VM インスタンスの詳細が表示されます。

SSH 認証鍵は自動的に転送されるため、ブラウザから直接 SSH 接続するために別のソフトウェアを使用する必要はありません。

- Compute Engine インスタンスに関する情報を確認するには、コマンドラインで次のコマンドを入力します。

次のような出力が表示されます。

タスク 3. ソフトウェアをインストールする

- 引き続き SSH ウィンドウで、次のコマンドを入力します。

-

追加のディスク容量の使用について同意を求めるメッセージが表示されたら、「Y」と入力します。

-

Git がインストールされたことを確認します。

次のような出力が表示されます。

下の [進行状況を確認] をクリックして、このラボの進捗状況を確認します。

タスク 4. USGS データを取り込む

- 引き続き SSH ウィンドウで、次のコマンドを入力して GitHub からコードをダウンロードします。

- このラボに対応するフォルダに移動します。

-

lessコマンドを使用して、ingestのコードを確認します。

less コマンドを使用すると、ファイルを表示できます(Space キーを押すと下へスクロール、b で 1 ページ戻り、q で終了します)。

- 「q」と入力してエディタを終了します。

プログラム ingest.sh により、アメリカ地質調査所から過去 7 日間の地震情報のデータセットがダウンロードされます。ファイルのダウンロード先を確認します(ディスクまたは Cloud Storage)。

- 次のコマンドを入力して

ingestのコードを実行します。

下の [進行状況を確認] をクリックして、このラボの進捗状況を確認します。

タスク 5. データを変換する

Python プログラムを使用して、元データを地震活動のマップに変換します。

変換コードについては、こちらのノートブックで詳しく説明されています。

この説明を読むと、何をするための変換コードかを理解できます。このノートブック自体は Datalab に書き込まれています。Datalab は Google Cloud プロダクトで、このコースで後ほど使用します。

- 引き続き Compute Engine インスタンスで、次のコマンドを入力して必要な Python パッケージを Compute Engine インスタンスにインストールします。

- 次のコマンドを入力して変換コードを実行します。

- 次のコマンドを入力すると、

earthquakes.pngという新しい画像ファイルが現在のディレクトリに作成されたことがわかります。

下の [進行状況を確認] をクリックして、このラボの進捗状況を確認します。

タスク 6. Cloud Storage バケットを作成する

このステップは Cloud Console に戻って行います。

-

ナビゲーション メニューで [Cloud Storage] を選択します。

-

[+ 作成] をクリックし、次のようなバケットを作成します。

- グローバルに一意のバケット名(ただし、実際のプロジェクトに使用する名前ではないもの)を指定し、[続行] をクリックします。

- [マルチリージョン] のままでも構いませんが、[リージョン] にすると速度が向上し、コストを抑えられます(Compute Engine インスタンスと同じリージョンを選択してください)。

- [

オブジェクトへのアクセスを制御する方法を選択する] で [このバケットに対する公開アクセス禁止を適用する] をオフにして、[アクセス制御] で [きめ細かい管理] を選択します。

- 次に、[作成] をクリックします。

バケット名をメモしておいてください。今後 <YOUR-BUCKET> の指定を求められたらその名前を入力します。

タスク 7. データを保存する

次に、変換前と変換後のデータを Cloud Storage に保存する方法を学びます。

- Compute Engine インスタンスの SSH ウィンドウで、次のコマンドを実行します。

<YOUR-BUCKET>は、先ほど作成したバケットの名前に変更してください。

このコマンドは、ファイルを Cloud Storage のバケットにコピーします。

- Cloud コンソールに戻り、Cloud Storage の [ブラウザ] ページでページ上部にある [更新] ボタンをクリックします。バケット名をクリックし、次に

/earthquakesフォルダをクリックします。

earthquakes フォルダに次の 3 つのファイルが追加されたことがわかります。

- earthquakes.csv

- earthquakes.htm

- earthquakes.png

下の [進行状況を確認] をクリックして、このラボの進捗状況を確認します。

タスク 8. Cloud Storage ファイルをウェブに公開する

次に、バケット内のファイルをウェブに公開します。

-

ファイル用の一般公開 URL を作成するには、

earthquakes.htmファイルの端にあるその他アイコンをクリックし、プルダウン メニューから [アクセス権の編集] を選択します。 -

表示されたオーバーレイで、[+ エントリを追加] ボタンをクリックします。

-

以下のように入力して、すべてのユーザーが対象の権限を追加します。

- [エンティティ] には [Public] を選択します。

- [名前] には「allUsers」と入力します。

- [アクセス権] には [読み取り] を選択します。

- [保存] をクリックします。

-

earthquakes.pngについて、上の手順を繰り返します。 -

ファイル名をクリックして、公開された Cloud Storage ファイルの URL を確認します。バケットの名前と内容に関連する URL が作成されたことがわかります。次のようになります。

- 画像ファイル

earthquakes.pngをクリックし、その公開 URL をクリックすると、新しいタブが開いて次の画像が読み込まれます。

- 完了したら SSH ウィンドウを閉じます。

お疲れさまでした

以上でこのラボは完了です。ここでは、Compute Engine インスタンスを起動してリモートからアクセスし、データを取得、処理、公開するためのパイプラインを手動で作成する方法を学びました。

クエストを完了する

このセルフペース ラボは、「Scientific Data Processing」クエストの一部です。クエストとは学習プログラムを構成する一連のラボのことで、完了すると成果が認められてバッジが贈られます。バッジは公開して、オンライン レジュメやソーシャル メディア アカウントにリンクできます。このラボの修了後、こちらのクエストまたはこのラボが含まれるクエストに登録すれば、すぐにクレジットを受け取ることができます。受講可能なすべてのクエストについては、Google Cloud Skills Boost カタログをご覧ください。

次のラボを受講する

「BigQuery の気象データ」に進んでクエストを続けるか、「Cloud Dataproc での分散画像処理」のラボをお試しください。

次のステップと詳細情報

フォローアップとして以下をご確認ください。

- 詳細については、USGS.gov をご覧ください。たとえば、次のような情報が得られます。

- 最近発生した世界の大地震上位 20 件

- 測地データ

- ハザード評価のデータとモデルなど

- 居住地域の地震情報を自動的に通知するサービスにご登録ください。

Google Cloud トレーニングと認定資格

Google Cloud トレーニングと認定資格を通して、Google Cloud 技術を最大限に活用できるようになります。必要な技術スキルとベスト プラクティスについて取り扱うクラスでは、学習を継続的に進めることができます。トレーニングは基礎レベルから上級レベルまであり、オンデマンド、ライブ、バーチャル参加など、多忙なスケジュールにも対応できるオプションが用意されています。認定資格を取得することで、Google Cloud テクノロジーに関するスキルと知識を証明できます。

マニュアルの最終更新日: 2023 年 10 月 16 日

ラボの最終テスト日: 2023 年 10 月 19 日

Copyright 2024 Google LLC All rights reserved. Google および Google のロゴは Google LLC の商標です。その他すべての企業名および商品名はそれぞれ各社の商標または登録商標です。

![[アクセス権の編集] ページ](https://cdn.qwiklabs.com/HNVCDhrj7iYd%2Fb4X3UCof0wL4EQ205FEEfXKWifsWSQ%3D)