Checkpoints

Create Cloud Composer environment.

/ 25

Create two Cloud Storage buckets.

/ 25

Create a dataset.

/ 25

Uploading the DAG and dependencies to Cloud Storage

/ 25

Cloud Composer: como copiar tabelas do BigQuery em diferentes locais

- GSP283

- Visão geral

- Configuração e requisitos

- Tarefa 1: criar um ambiente do Cloud Composer

- Tarefa 2: criar buckets do Cloud Storage

- Tarefa 3: criar o conjunto de dados de destino do BigQuery

- Tarefa 4: breve introdução aos conceitos básicos do Airflow

- Tarefa 5: definir o fluxo de trabalho

- Tarefa 6: ver informações do ambiente

- Tarefa 7: criar uma variável para o bucket de DAGs no Cloud Storage

- Tarefa 8: definir variáveis do Airflow

- Tarefa 9: fazer upload do DAG e das dependências para o Cloud Storage

- Tarefa 10. conhecer a interface do Airflow

- Tarefa 11: validar os resultados

- Excluir ambiente do Cloud Composer

- Parabéns!

- Próximas etapas

GSP283

Visão geral

Imagine que você tem conjuntos de dados em diversos lugares do mundo e que seus dados estão em buckets do Google Cloud Storage ou em tabelas do BigQuery. Como eles podem ser organizados para que sejam consolidados e analisados, oferecendo insights sobre sua empresa?

O Cloud Composer permite criar fluxos de trabalho e mover seus dados entre regiões e sistemas de armazenamento usando uma interface gráfica intuitiva. Entre outros benefícios, o serviço conta com modelos confiáveis e fáceis de usar para transferir seus dados entre o BigQuery e o Cloud Storage.

Neste laboratório, você vai criar e executar um fluxo de trabalho do Apache Airflow no Cloud Composer que realiza as seguintes tarefas:

- Lê um arquivo de configuração que fornece uma lista de tabelas a serem copiadas

- Exporta a lista de tabelas de um conjunto de dados do BigQuery localizado nos EUA para o Cloud Storage

- Copia as tabelas exportadas do bucket do Cloud Storage nos EUA para o bucket do Cloud Storage na UE

- Importa a lista de tabelas para o conjunto de dados de destino do BigQuery na UE

Atividades deste laboratório

Neste laboratório, você vai aprender a:

- Criar um ambiente do Cloud Composer

- Criar buckets do Cloud Storage

- Criar conjuntos de dados do BigQuery

- Criar e executar fluxos de trabalho do Apache Airflow no Cloud Composer para transferir dados entre o Cloud Storage e o BigQuery

Configuração e requisitos

Antes de clicar no botão Start Lab

Leia estas instruções. Os laboratórios são cronometrados e não podem ser pausados. O timer é iniciado quando você clica em Começar o laboratório e mostra por quanto tempo os recursos do Google Cloud vão ficar disponíveis.

Este laboratório prático permite que você realize as atividades em um ambiente real de nuvem, não em uma simulação ou demonstração. Você vai receber novas credenciais temporárias para fazer login e acessar o Google Cloud durante o laboratório.

Confira os requisitos para concluir o laboratório:

- Acesso a um navegador de Internet padrão (recomendamos o Chrome).

- Tempo para concluir o laboratório---não se esqueça: depois de começar, não será possível pausar o laboratório.

Como iniciar seu laboratório e fazer login no console do Google Cloud

-

Clique no botão Começar o laboratório. Se for preciso pagar, você verá um pop-up para selecionar a forma de pagamento. No painel Detalhes do laboratório à esquerda, você verá o seguinte:

- O botão Abrir Console do Cloud

- Tempo restante

- As credenciais temporárias que você vai usar neste laboratório

- Outras informações se forem necessárias

-

Clique em Abrir Console do Google. O laboratório ativa recursos e depois abre outra guia com a página Fazer login.

Dica: coloque as guias em janelas separadas lado a lado.

Observação: se aparecer a caixa de diálogo Escolher uma conta, clique em Usar outra conta. -

Caso seja preciso, copie o Nome de usuário no painel Detalhes do laboratório e cole esse nome na caixa de diálogo Fazer login. Clique em Avançar.

-

Copie a Senha no painel Detalhes do laboratório e a cole na caixa de diálogo Olá. Clique em Avançar.

Importante: você precisa usar as credenciais do painel à esquerda. Não use suas credenciais do Google Cloud Ensina. Observação: se você usar sua própria conta do Google Cloud neste laboratório, é possível que receba cobranças adicionais. -

Acesse as próximas páginas:

- Aceite os Termos e Condições.

- Não adicione opções de recuperação nem autenticação de dois fatores (porque essa é uma conta temporária).

- Não se inscreva em testes gratuitos.

Depois de alguns instantes, o console do GCP vai ser aberto nesta guia.

Ativar o Cloud Shell

O Cloud Shell é uma máquina virtual com várias ferramentas de desenvolvimento. Ele tem um diretório principal permanente de 5 GB e é executado no Google Cloud. O Cloud Shell oferece acesso de linha de comando aos recursos do Google Cloud.

- Clique em Ativar o Cloud Shell

na parte de cima do console do Google Cloud.

Depois de se conectar, vai notar que sua conta já está autenticada, e que o projeto está configurado com seu PROJECT_ID. A saída contém uma linha que declara o projeto PROJECT_ID para esta sessão:

gcloud é a ferramenta de linha de comando do Google Cloud. Ela vem pré-instalada no Cloud Shell e aceita preenchimento com tabulação.

- (Opcional) É possível listar o nome da conta ativa usando este comando:

-

Clique em Autorizar.

-

A saída será parecida com esta:

Saída:

- (Opcional) É possível listar o ID do projeto usando este comando:

Saída:

Exemplo de saída:

gcloud, acesse o guia com informações gerais sobre a gcloud CLI no Google Cloud.

Tarefa 1: criar um ambiente do Cloud Composer

- Primeiro, crie um ambiente do Cloud Composer clicando em Composer no Menu de navegação.

-

Depois, clique em Criar ambiente.

-

No menu suspenso, selecione Composer 2.

-

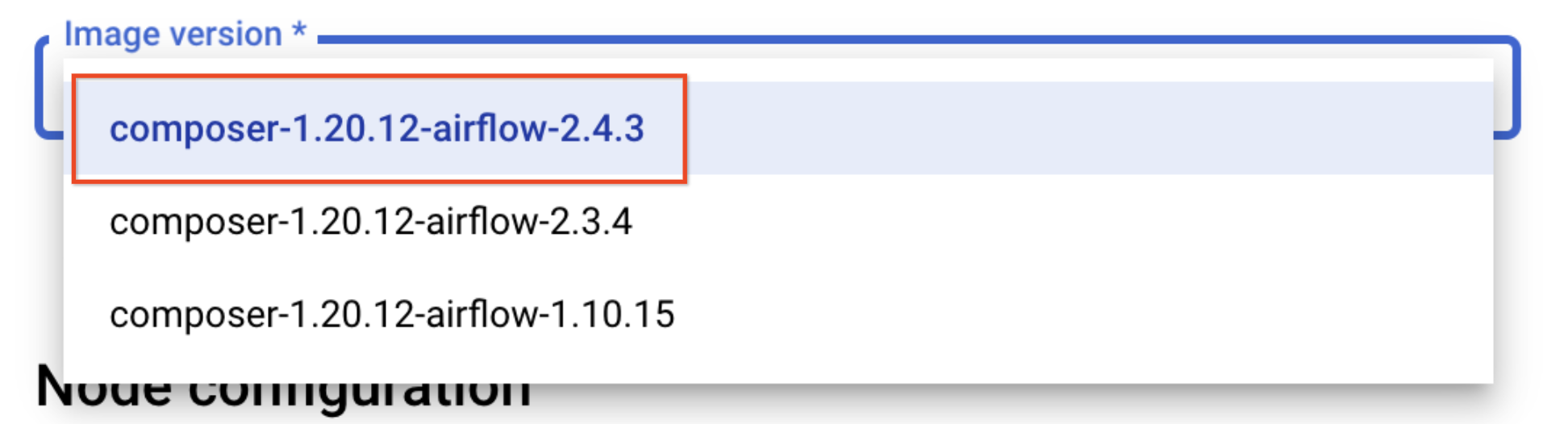

Defina os parâmetros a seguir para o ambiente:

- Nome: composer-advanced-lab

-

Local:

- Versão de imagem: composer-2.6.2-airflow-2.6.3

-

Marque a caixa de seleção Conceder permissões necessárias à conta de serviço do Cloud Composer e clique em Conceder.

-

Clique no menu suspenso para Mostrar configuração avançada e selecione Zona do banco de dados do Airflow como

.

Não altere as outras configurações.

- Clique em Criar.

O processo de criação do ambiente será concluído quando uma marca de seleção verde for exibida à esquerda do nome dele na página "Ambientes" no console do Cloud.

"Criar buckets do Cloud Storage" e "Conjunto de dados de destino do BigQuery".Clique em Verificar meu progresso para conferir o objetivo.

Tarefa 2: criar buckets do Cloud Storage

Nesta tarefa, você vai criar dois buckets multirregionais do Cloud Storage. Esses buckets serão usados para copiar as tabelas exportadas entre os locais, neste caso EUA e UE.

Criar um bucket nos EUA

- Acesse Cloud Storage > Bucket e clique em Criar.

- Dê ao bucket um nome exclusivo que inclua o ID do projeto (por exemplo,

-eua). - Em Tipo de local, selecione EUA (várias regiões nos Estados Unidos).

- Deixe os demais valores como padrão e clique em Criar.

- Marque a caixa

Aplicar a prevenção do acesso público neste buckete clique em Confirmar no pop-upO acesso público será bloqueado, se necessário.

Criar um bucket na UE

Repita as etapas para criar outro bucket na região da UE. O nome exclusivo precisa incluir o local como um sufixo do bucket (por exemplo,

Clique em Verificar meu progresso para conferir o objetivo.

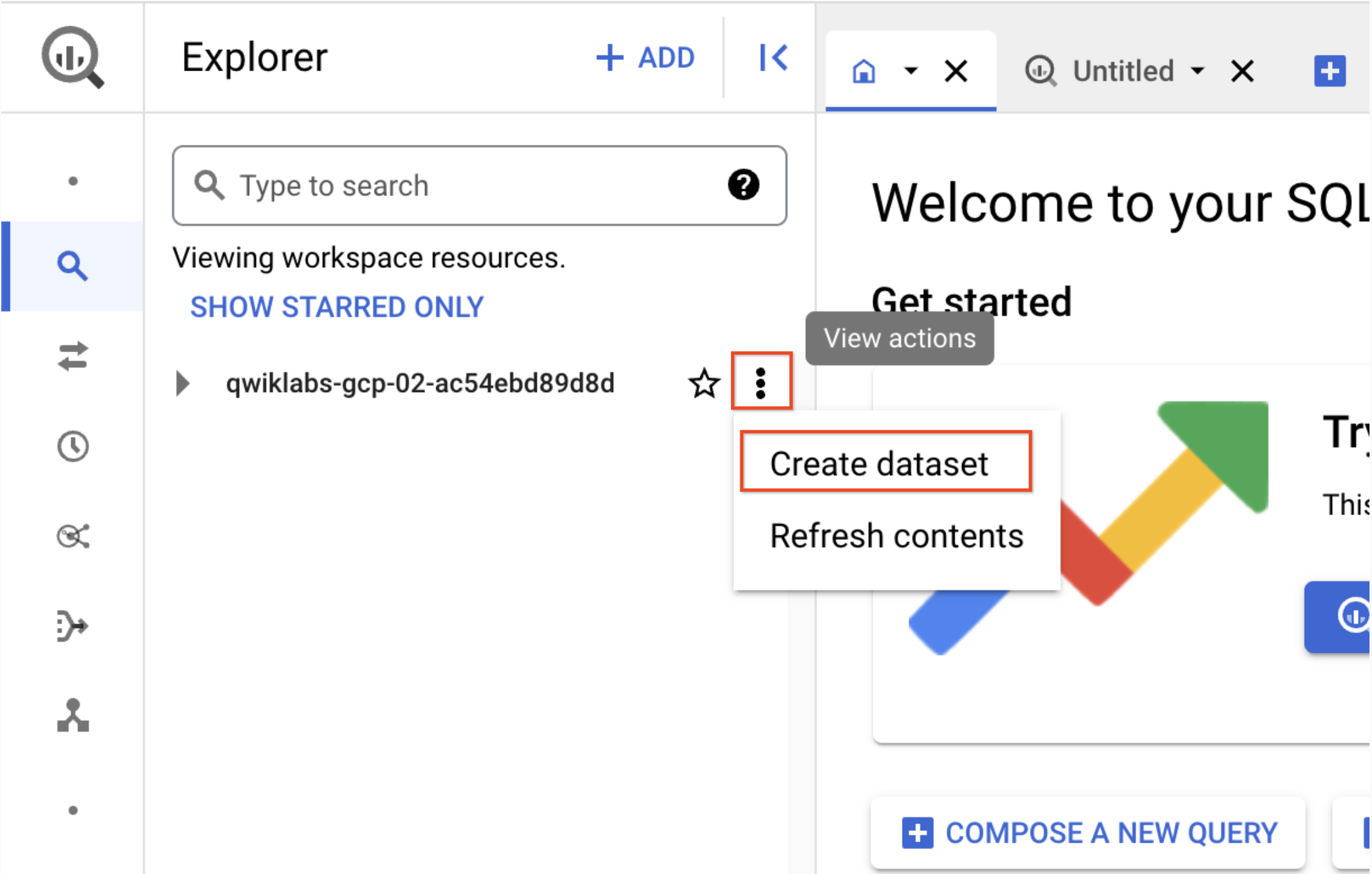

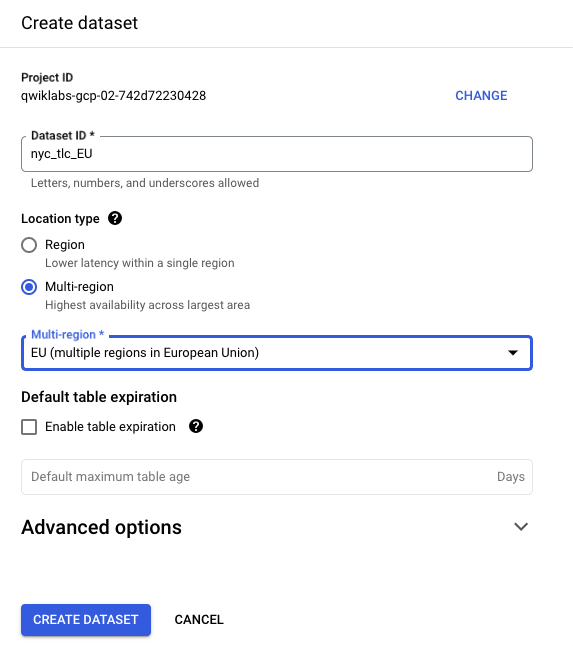

Tarefa 3: criar o conjunto de dados de destino do BigQuery

-

Crie o conjunto de dados de destino do BigQuery na UE com a nova interface da Web do BigQuery.

-

Acesse Menu de navegação > BigQuery.

Você verá a caixa de mensagem Olá! Este é o BigQuery no Console do Cloud. Ela tem um link para o guia de início rápido e lista as atualizações da interface.

-

Clique em Concluído.

-

Em seguida, clique nos três pontos ao lado do ID do projeto do Qwiklabs e selecione Criar conjunto de dados.

- Use o ID do conjunto de dados nyc_tlc_EU, escolha multirregional como o tipo do local e selecione UE no menu suspenso.

- Clique em CRIAR CONJUNTO DE DADOS.

Clique em Verificar meu progresso para conferir o objetivo.

Tarefa 4: breve introdução aos conceitos básicos do Airflow

- Enquanto espera o ambiente ficar pronto, leia sobre o arquivo de amostra que você usará neste laboratório.

O Airflow (links em inglês) é uma plataforma para criar, programar e monitorar fluxos de trabalho programaticamente.

Use o Airflow para criar fluxos de trabalho, como gráficos acíclicos dirigidos (DAGs, na sigla em inglês) de tarefas. O programador do Airflow executa suas tarefas em uma matriz de workers enquanto segue as dependências especificadas.

Conceitos básicos

DAG: um gráfico acíclico dirigido é um conjunto de tarefas organizadas para refletir as relações e dependências entre elas.

Operador: é a descrição de uma única tarefa. Em geral, os operadores são atômicos. Por exemplo, o operador BashOperator é usado para executar o comando "bash".

Tarefa: uma instância parametrizada de um operador. As tarefas são nós no DAG.

Instância de tarefa: a execução específica de uma tarefa. Composta de um DAG, uma tarefa e um ponto no tempo. Ela tem sempre um estado indicativo, por exemplo: running, success, failed, skipped etc.

Aprenda os conceitos do Airflow na Documentação sobre conceitos.

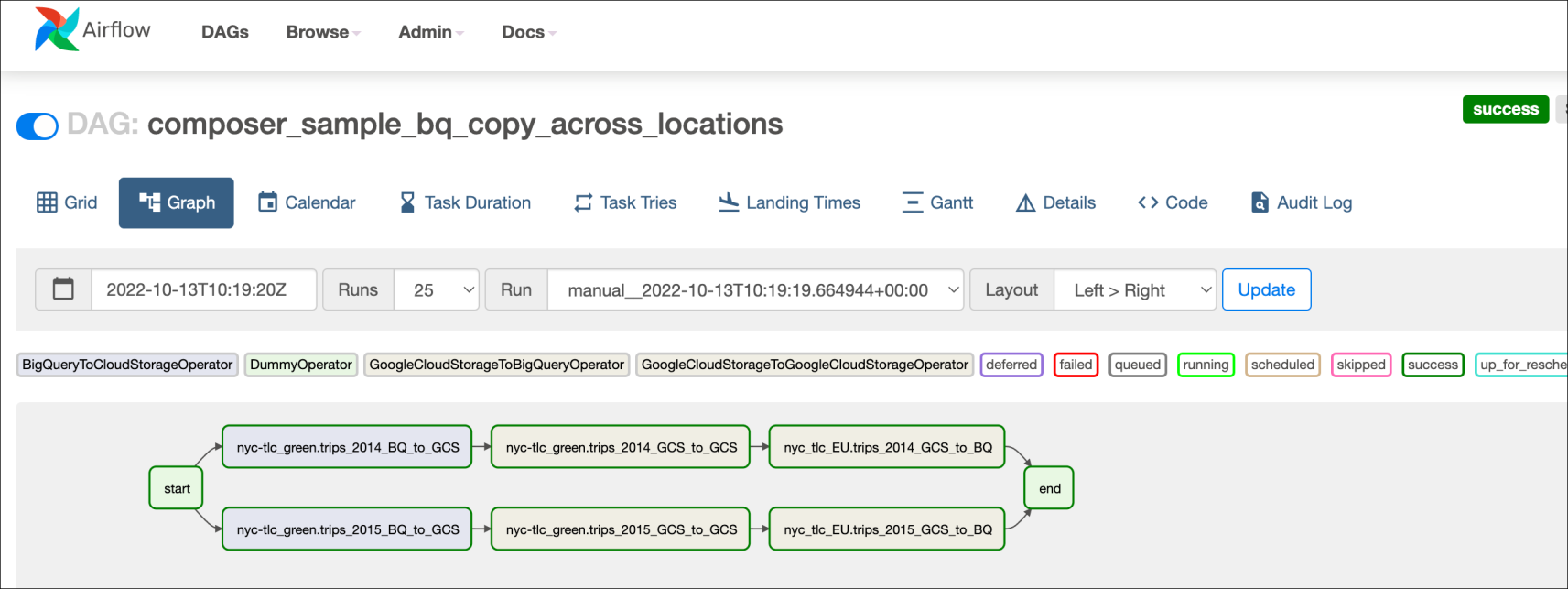

Tarefa 5: definir o fluxo de trabalho

No Cloud Composer, os fluxos de trabalho são compostos de gráficos acíclicos dirigidos (DAGs). O código do fluxo de trabalho, também conhecido como DAG, está no arquivo bq_copy_across_locations.py. Abra o arquivo para ver a estrutura do código. Alguns dos principais componentes do arquivo serão detalhados a seguir.

Para orquestrar todas as tarefas do fluxo de trabalho, o DAG importa estes operadores:

-

DummyOperator: cria tarefas fictícias de início e término para gerar uma representação visual melhor do DAG. -

BigQueryToCloudStorageOperator: exporta tabelas do BigQuery para os buckets do Cloud Storage usando o formato Avro. -

GoogleCloudStorageToGoogleCloudStorageOperator: copia arquivos para os buckets do Cloud Storage. -

GoogleCloudStorageToBigQueryOperator: importa tabelas de arquivos Avro no bucket do Cloud Storage.

- Neste exemplo, a função

read_table_list()está definida para ler o arquivo de configuração e criar a lista das tabelas a serem copiadas.

- O nome do DAG é

bq_copy_us_to_eu_01. Como o DAG não é programado por padrão, requer acionamento manual.

- Para definir o plug-in do Cloud Storage, a classe

Cloud StoragePlugin(AirflowPlugin)é definida mapeando o hook e o operador baixados da ramificação estável do Airflow 1.10.

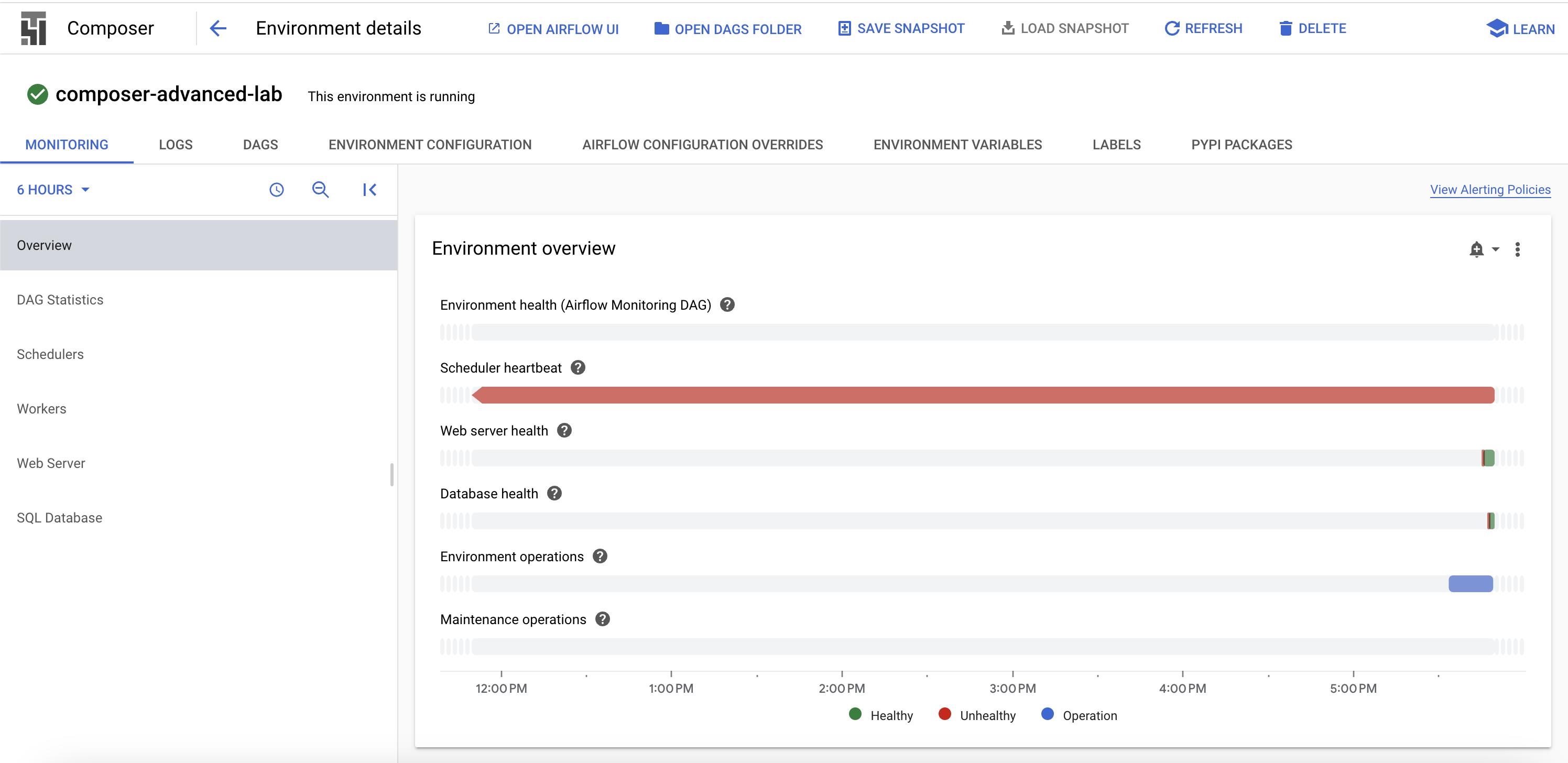

Tarefa 6: ver informações do ambiente

-

Volte ao Composer para verificar o status do ambiente.

-

Depois que seu ambiente for criado, clique no nome dele para ver os detalhes.

A página Detalhes do ambiente mostra o URL da IU da Web do Airflow, o ID do cluster do Google Kubernetes Engine e o nome do bucket do Cloud Storage conectado à pasta de DAGs.

As próximas etapas precisam ser concluídas no Cloud Shell.

Como criar um ambiente virtual

Os ambientes virtuais Python são usados para isolar do sistema a instalação de pacotes.

- Instale o ambiente

virtualenv:

- Crie o ambiente virtual:

- Ative o ambiente virtual.

Tarefa 7: criar uma variável para o bucket de DAGs no Cloud Storage

- Para copiar o nome do bucket de DAGs na página "Detalhes do ambiente" e definir uma variável associada a ele, execute o seguinte no Cloud Shell:

us-east1-composer-advanced-YOURDAGSBUCKET-bucket.Essa variável vai ser usada algumas vezes durante o laboratório.

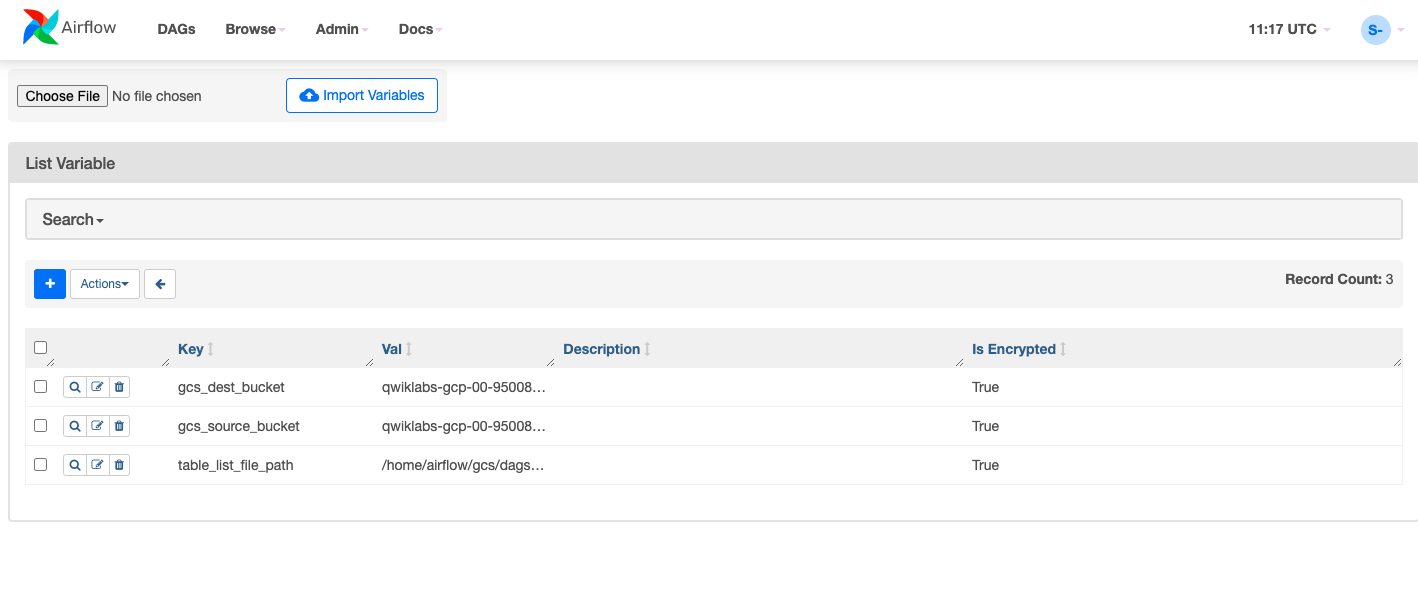

Tarefa 8: definir variáveis do Airflow

As variáveis do Airflow são um conceito específico dessa plataforma e diferem das variáveis de ambiente. Nesta seção, você vai definir as três variáveis do Airflow usadas pelo DAG que vamos implantar: table_list_file_path, gcs_source_bucket e gcs_dest_bucket.

| Chave | Valor | Detalhes |

|---|---|---|

table_list_file_path |

/home/airflow/gcs/dags/bq_copy_eu_to_us_sample.csv | O arquivo CSV que lista as tabelas de origem e de destino, incluindo o conjunto de dados. |

gcs_source_bucket |

{UNIQUE ID}-us | O bucket do Cloud Storage que será usado para exportar da origem a tabela tabledest_bbucks do BigQuery |

gcs_dest_bucket |

{UNIQUE ID}-eu | O bucket do Cloud Storage que será usado para importar as tabelas do BigQuery para o destino |

O comando gcloud composer executa o subcomando variables da CLI do Airflow. O subcomando transmite os argumentos para a ferramenta de linha de comando gcloud.

Para definir as três variáveis, você executará composer command uma vez para cada linha da tabela acima. Este é o formato do comando:

(ERROR: gcloud crashed (TypeError): 'NoneType' object is not callable). Esse é um problema conhecido relacionado ao uso do comando gcloud composer environments run na versão 410.0.0 do gcloud. Suas variáveis ainda vão ser definidas, apesar da mensagem de erro.

-

ENVIRONMENT_NAMEé o nome do ambiente. -

LOCATIONé a região do Compute Engine onde o ambiente está. Para executar o comando gcloud composer, é necessário incluir a sinalização--locationou a configuração do local padrão. -

KEYeVALUEespecificam a variável e o valor correspondente que você precisa definir. À esquerda do comandogcloud, adicione dois traços (--) e depois os argumentos relacionados ao gcloud. Inclua os argumentos referentes ao subcomando do Airflow do lado direito. Dê um espaço entre os argumentosKEYeVALUEusando o comandogcloud composer environments runcom o subcomando de variáveis.

Execute os comandos no Cloud Shell, trocando gcs_source_bucket e gcs_dest_bucket pelos nomes dos buckets criados na Tarefa 2.

Para ver o valor de uma variável, execute as variáveis do subcomando da CLI do Airflow com o argumento get ou use a IU do Airflow.

Por exemplo, execute o seguinte:

Tarefa 9: fazer upload do DAG e das dependências para o Cloud Storage

- Copie no seu Cloud Shell os arquivos de amostra de documentos de Python do Google Cloud:

- Faça upload de uma cópia do hook e do operador de terceiros na pasta de plug-ins do seu bucket de DAGs do Composer armazenado no Cloud Storage:

- Depois faça upload do DAG e do arquivo de configuração no bucket de DAGs no Cloud Storage do seu ambiente:

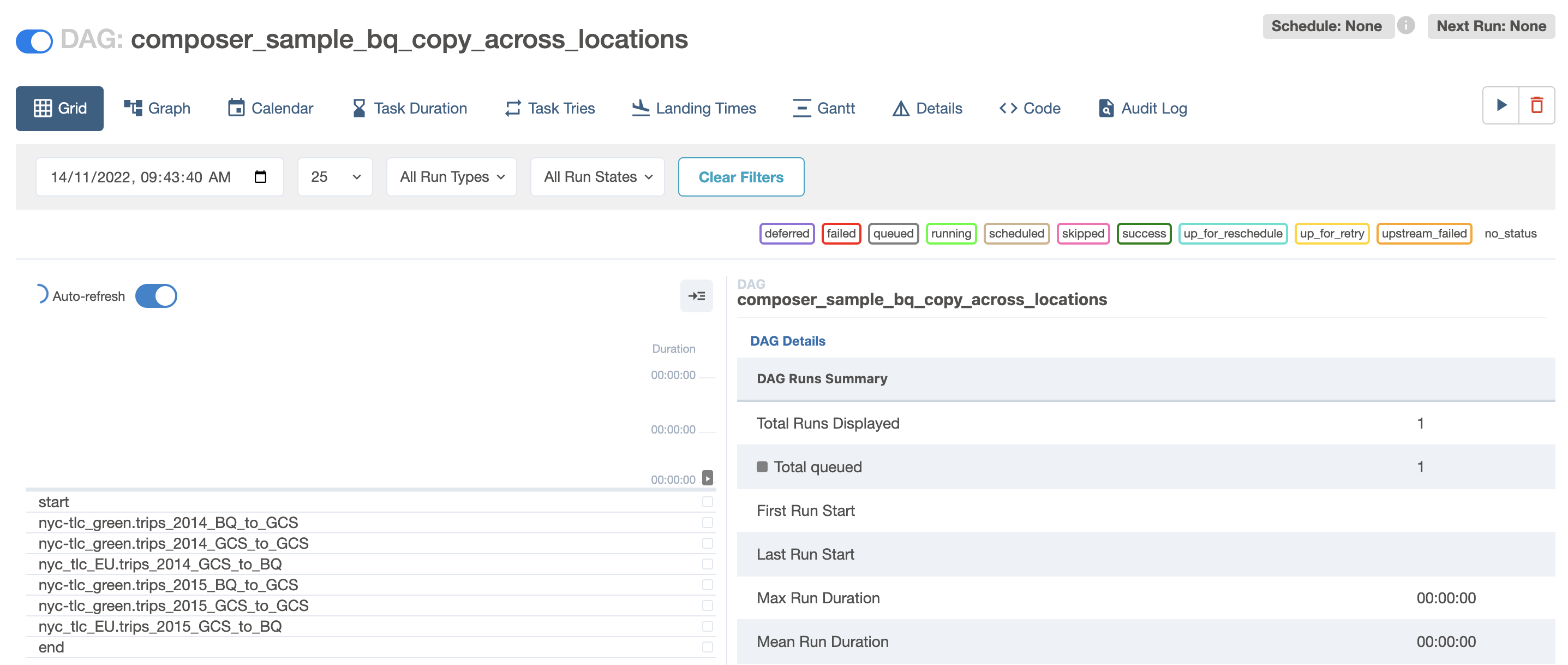

O Cloud Composer registra o DAG automaticamente no seu ambiente do Airflow. As alterações no DAG levam de 3 a 5 minutos para serem feitas. É possível conferir o status da tarefa na interface da Web do Airflow e confirmar se o DAG não está programado de acordo com as configurações.

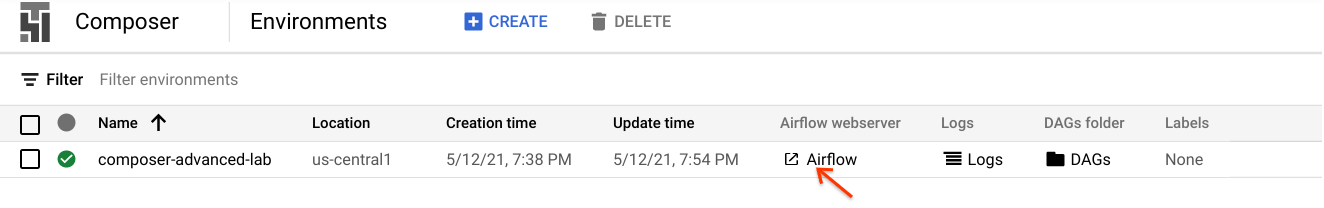

Tarefa 10. conhecer a interface do Airflow

Para acessar a interface da Web do Airflow pelo console do Cloud, siga estas etapas:

- Volte para a página Ambientes do Composer.

- Na coluna Servidor da Web do Airflow para o ambiente, clique no link Airflow.

- Clique nas suas credenciais do laboratório.

- A interface da Web do Airflow é aberta em uma nova janela do navegador. Os dados ainda estarão sendo carregados nesta etapa. Você pode continuar com o laboratório enquanto isso.

Como conferir as variáveis

As variáveis já definidas são mantidas no seu ambiente.

- Para conferir as variáveis, selecione Admin > Variables na barra de menus do Airflow.

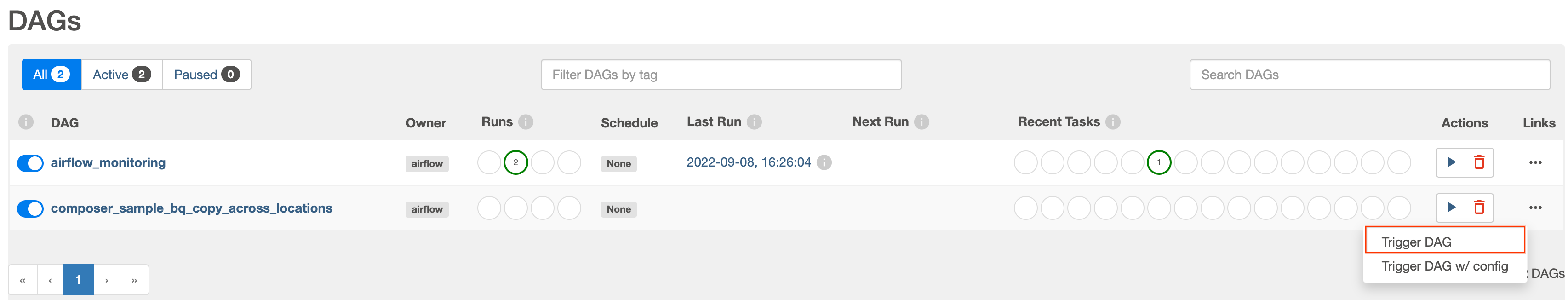

Como acionar o DAG manualmente

-

Clique na guia DAGs e aguarde os links serem carregados.

-

Para acionar o DAG manualmente, clique no botão de reprodução para

composer_sample_bq_copy_across_locations:

- Clique em Acionar DAG para confirmar a ação.

Clique em Verificar meu progresso para conferir o objetivo.

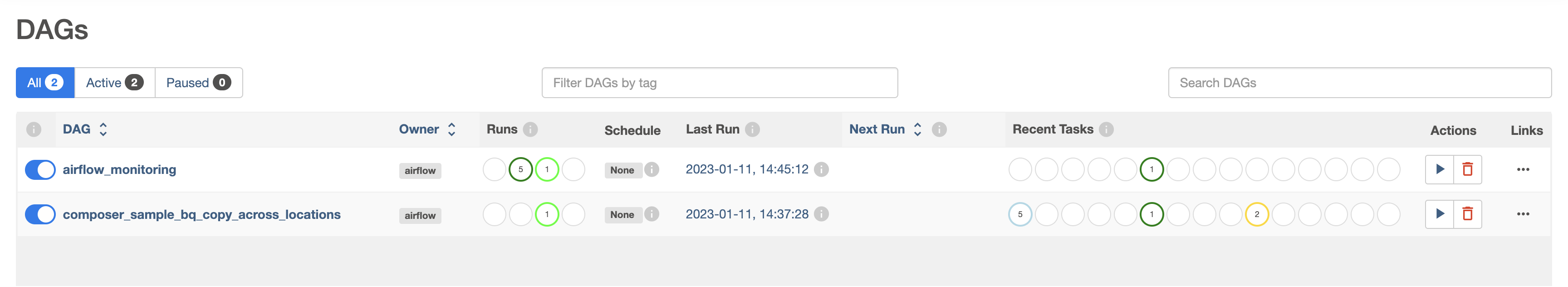

Como o DAG é executado

O Cloud Composer analisa seu arquivo DAG durante o upload para a pasta de DAGs no Cloud Storage. Se nenhum erro for encontrado, o nome do fluxo de trabalho vai aparecer na lista de DAGs. Em seguida, o fluxo de trabalho vai entrar na fila para execução imediata se as condições de programação forem atendidas. Neste caso, nenhuma foi configurada.

Quando o botão de reprodução é pressionado, o status das Execuções fica verde:

- Clique no nome do DAG para abrir a página de detalhes correspondente. Nela, você encontra uma representação gráfica das tarefas e das dependências do fluxo de trabalho.

- Na barra de ferramentas, clique em Gráfico e passe o ponteiro do mouse sobre o gráfico das tarefas para conferir o status de cada uma. A borda das tarefas também indica o status: verde = em execução, vermelha = falha etc.

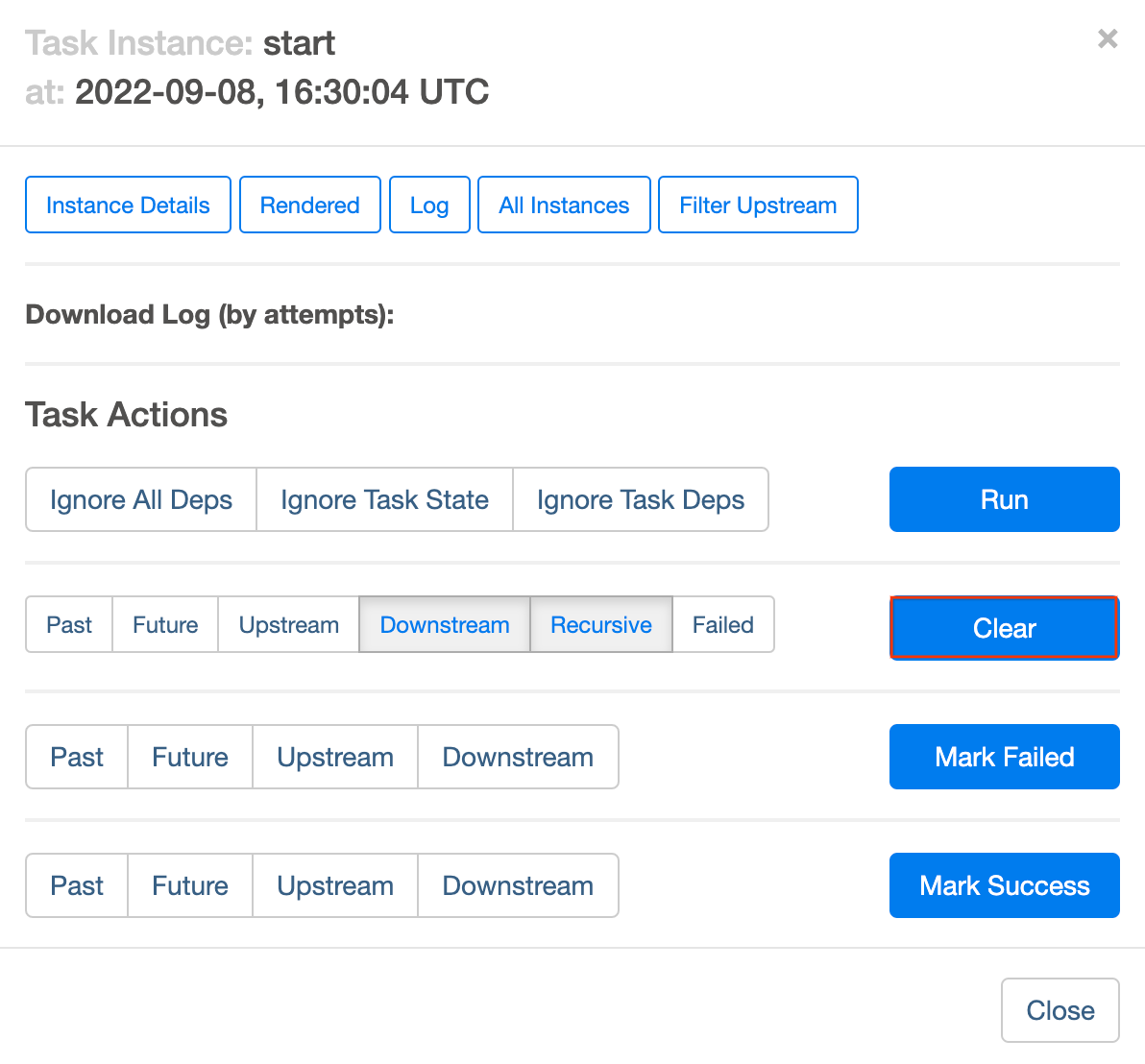

Para executar o fluxo de trabalho outra vez na visualização Graph:

- Na visualização Graph na IU do Airflow, clique no gráfico start.

- Clique em Clear para redefinir todas as tarefas e depois em OK para confirmar.

Enquanto o processo está em execução, atualize seu navegador e confira as informações mais recentes.

Tarefa 11: validar os resultados

Agora verifique o status e os resultados do fluxo de trabalho nas seguintes páginas do Console do Cloud:

- As tabelas exportadas foram copiadas do bucket dos EUA para o bucket do Cloud Storage na UE. Clique em Cloud Storage para ver os arquivos Avro intermediários nos buckets de origem (EUA) e de destino (UE).

- As tabelas da lista foram importadas para o conjunto de dados de destino do BigQuery. Clique em BigQuery e depois no nome do seu projeto e no conjunto de dados nyc_tlc_EU para confirmar que as tabelas podem ser acessadas pelo conjunto de dados que você criou.

Excluir ambiente do Cloud Composer

- Retorne à página Ambientes no Composer.

- Marque a caixa de seleção ao lado do ambiente do Composer.

- Clique em EXCLUIR.

- Confirme o pop-up clicando em EXCLUIR novamente.

Parabéns!

Você copiou de forma programática as tabelas localizadas nos EUA para a UE. Este laboratório é baseado na postagem do blog de David Sabater Dinter.

Próximas etapas

- Consulte o site do Airflow ou este projeto do GitHub para saber mais sobre a plataforma.

- Há vários outros recursos disponíveis para o Airflow, inclusive um grupo de discussão.

- Crie uma conta no Apache JIRA e reabra todas as questões importantes no projeto Apache Airflow JIRA.

- Para saber mais sobre a interface do Airflow, consulte Como acessar a interface da Web.

Treinamento e certificação do Google Cloud

Esses treinamentos ajudam você a aproveitar as tecnologias do Google Cloud ao máximo. Nossas aulas incluem habilidades técnicas e práticas recomendadas para ajudar você a alcançar rapidamente o nível esperado e continuar sua jornada de aprendizado. Oferecemos treinamentos que vão do nível básico ao avançado, com opções de aulas virtuais, sob demanda e por meio de transmissões ao vivo para que você possa encaixá-las na correria do seu dia a dia. As certificações validam sua experiência e comprovam suas habilidades com as tecnologias do Google Cloud.

Manual atualizado em 12 de março de 2024

Laboratório testado em 12 de março de 2024

Copyright 2024 Google LLC. Todos os direitos reservados. Google e o logotipo do Google são marcas registradas da Google LLC. Todos os outros nomes de produtos e empresas podem ser marcas registradas das respectivas empresas a que estão associados.